《U-Net: Convolutional Networks for Biomedical Image Segmentation》阅读笔记

前言

让我们呢,从最初开始。

Abstract

人们普遍认为深度网络的训练需要大量的标签训练样本。本文提出了一种网络架构和训练策略,可以在数据增强的强大使用下更有效利用。然后介绍了一下这个网络的结构:包括用于捕捉上下文的收缩路径和用于实现精确定位的对称扩展路径。介绍这种网络的优势:可以在很小的图片集上端对端训练,并且在ISBI challenge上优于先前最好的方法。并且通过在透射光学显微镜图像上训练的该网络以巨大优势赢得了ISBI2015 cell tracking challenge。速度也很快,在目前(2015)GPU 上,一张512 512的图像分割只需要不到 1s 的时间。最后介绍可以在 http://lmb.informatik.uni-freiburg.de/people/ronneber/u-net 上查看implementation(based on Caffe)。

Introduction

【深度网路在视觉任务中的进程】

在过去两年,在许多视觉识别任务中深度卷积网络的性能超过目前最先进的技术,如[7, 3]。虽然深度网络存在时间很长了[8],但是它们被训练集的大小和网络大小所限制,Krizhevsky等人[7]的突破是在一个具有8层和百万参数的大型网络上对具有100万个训练图像的ImageNet数据集上进行了训练。从此之后,更大更深的网络也被训练出来[12]。

[7] Krizhevsky, A., Sutskever, I., Hinton, G.E.: Imagenet classification with deep convolutional neural networks. In: NIPS. pp. 1106–1114 (2012)

[3] Girshick, R., Donahue, J., Darrell, T., Malik, J.: Rich feature hierarchies for accurate object detection and semantic segmentation. In: Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition (CVPR) (2014)

[8] LeCun, Y., Boser, B., Denker, J.S., Henderson, D., Howard, R.E., Hubbard, W., Jackel, L.D.: Backpropagation applied to handwritten zip code recognition. Neural Computation 1(4), 541–551 (1989)

[12] Simonyan, K., Zisserman, A.: Very deep convolutional networks for large-scale image recognition (2014), arXiv:1409.1556 [cs.CV]

【医学分割上目前最好的网络架构介绍】

卷积神经网络的典型用途是分类任务,其中图像输出的是单个类别标签,比如猫阿狗啊。但在许多视觉任务的处理中,特别是在医学分割上,期望的输出包括localization,即(i.e.),应该每个像素都有类别标签。而且在医学上成千上万的训练图像通常是很难达到的,因此Ciresan等人[1]在sliding-window设置训练了一个网络通过输入的像素点周围提供的一个局部区域(patch)来预测每个像素的类标签。首先,这个网络可以localize。其次,以patch为单位的训练数据远远大于训练图像。于是该网络在2012年的ISBI的EM分割挑战赛中以很大优势胜出。

【接下来,分析他人缺点,并提出最近一些论文解决了该缺点而使用的方法】

显而易见,[1]提出的网络结构有两个缺点。第一,太慢了,因为需要在每个patch上分别run,而且有大量冗余在重叠patch部分。第二,在localization accuracy(定位精确度)和use of context(上下文的使用上)会有一个权衡——较大的patch需要更多地最大池化层,但这会降低定位精度,而较小的patch只允许网络得到小的上下文信息。最近的方法[11,4]提出了一种分类器输出that考虑了多层特征。可能让定位精度和上下文的使用上同时达到GOOD的程度。

[1] Ciresan, D.C., Gambardella, L.M., Giusti, A., Schmidhuber, J.: Deep neural networks segment neuronal membranes in electron microscopy images. In: NIPS. pp. 2852–2860 (2012)

[11] Seyedhosseini, M., Sajjadi, M., Tasdizen, T.: Image segmentation with cascaded hierarchical models and logistic disjunctive normal networks. In: Computer Vision (ICCV), 2013 IEEE International Conference on. pp. 2168–2175 (2013)

[4] Hariharan, B., Arbelez, P., Girshick, R., Malik, J.: Hypercolumns for object segmentation and fine-grained localization (2014), arXiv:1411.5752 [cs.CV]

【介绍本片论文】

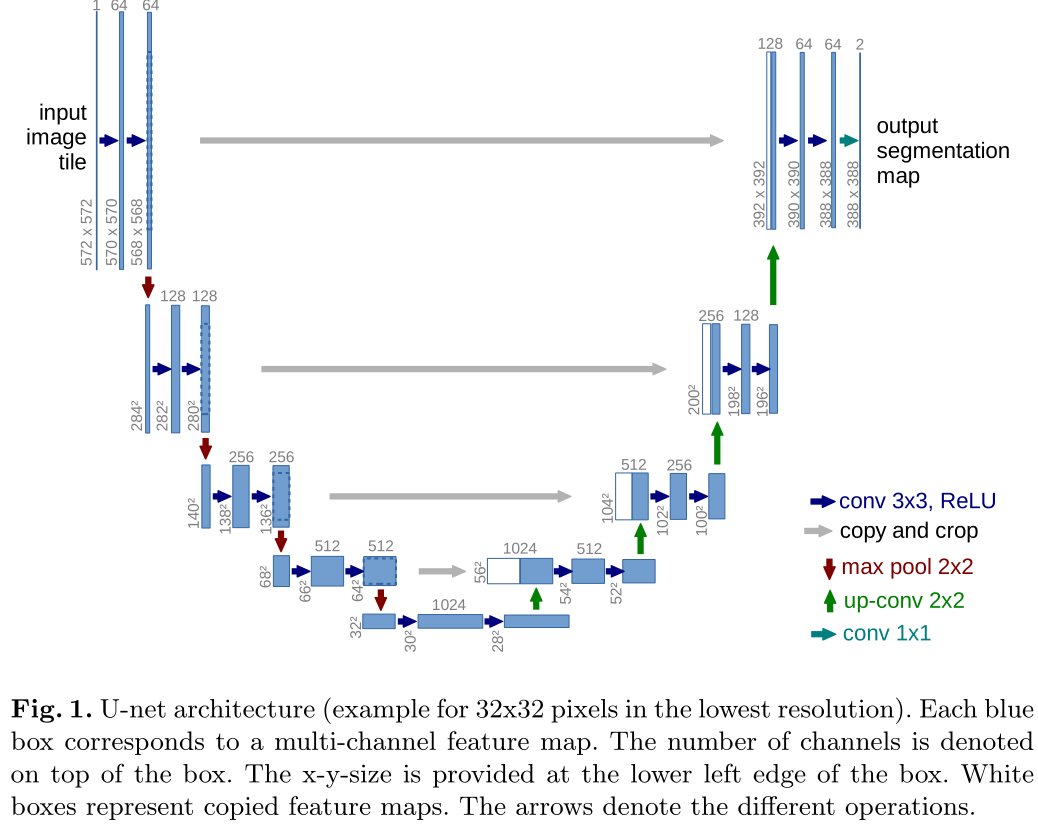

在这片论文中,我们建立在一个更优雅的架构上——全卷积网络[9]。我们修改和扩充了这个架构使其能在更小的训练集并产生更精确的分割结果,见图1(see Figure 1)。

[9]的中心思想主要是通过连续层来补充下采样网络(contracting network),其中池化操作被上采样操作代替。因此,这些层提高了输出的分辨率。为了精准定位,将下采样和上采样的高分辨率图像combine。随后,连续卷基层学习这个信息可以得到更精确的输出。

[9] Long, J., Shelhamer, E., Darrell, T.: Fully convolutional networks for semanticsegmentation (2014), arXiv:1411.4038 [cs.CV]

阐述我们提出的网络的修改。在上采样部分,我们也有大量的特征通道允许网络将上下文信息传播到更高分辨率的层。

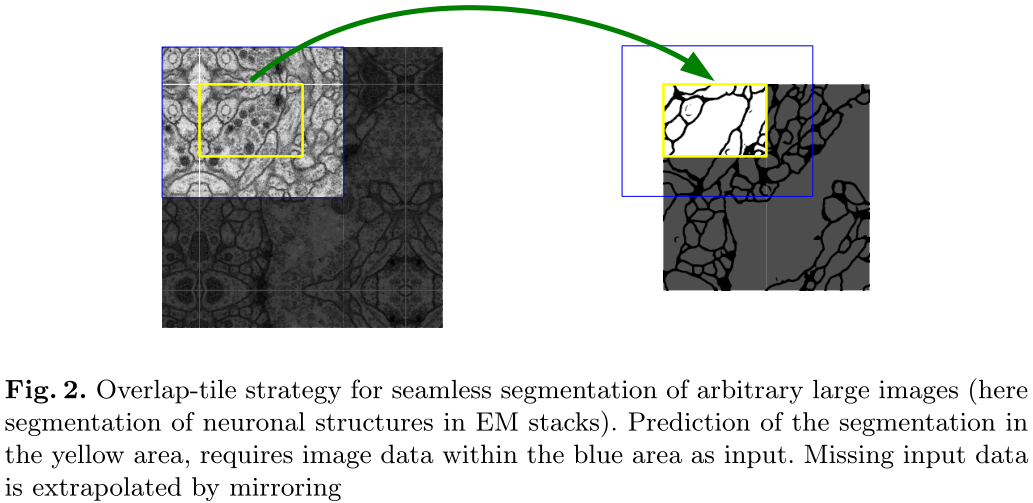

因此,上采样和下采样差不多是对称的 ,产生了U型结构。U-net也没有全连接层,是一个FCN的架构网络。网络的最终的分割图像是与输入像素相同的图像。运用了overlap-tile(see Figure 2)策略,使得在任意图像分类上都达到无缝分割。

overlap-tile策略:对图片缺失的上下文进行了镜像,使得图像边缘也能很好的分割。

这种策略对于大图像很重要,否则分辨率会受到GPU内存限制。(这个策略基于GPU内存不够的情况下所提出的)

接下来就是对小数量的数据集做数据增强。这在医学图像分割中特别重要。

在无监督的特征学习中,数据加强对于学习不变性的价值已经在[2]中凸显出来了。

This allows the network to learn invariance to such deformations, without the need to see these transformations in the annotated image corpus. This is particularly important in biomedical segmentation, since deformation used to be the most common variation in tissue and realistic deformations can be simulated efficiently.

[2] Dosovitskiy, A., Springenberg, J.T., Riedmiller, M., Brox, T.: Discriminative unsupervised feature learning with convolutional neural networks. In: NIPS (2014)

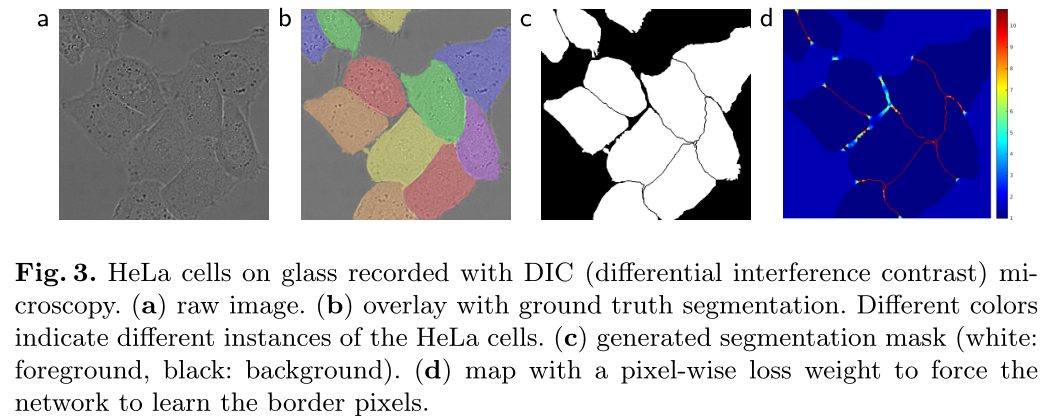

细胞分割任务中的另一个挑战就是同类且相互接触细胞的分离(see Figure 3)。为此,提出使用加权loss,也就是赋予相互接触的两个细胞之间的background标签更高的权重。

【总结,谈贡献】

该网络结构适合各种医学分割问题。在这篇论文中,我们展示了在neuronal structures in EM stacks (an ongoing competition started at ISBI 2012)的分割结果,我们的表现优于Ciresan等人的网络[1]。此外,我们还展示了2015的ISBI cell tracking challenge的分割结果,我们在两个most challenging的2D 透射光数据集上断层第一哦!

[1] Ciresan, D.C., Gambardella, L.M., Giusti, A., Schmidhuber, J.: Deep neural networks segment neuronal membranes in electron microscopy images. In: NIPS. pp. 2852–2860 (2012)

Network Architecture

The network architecture is illustrated in Figure 1.

其实图片介绍很清晰,每个箭头的不同含义也都介绍了。

介绍网络架构,如double卷积,池化层,stride等等等。

- 左边是下采样,右边是上采样。

- 下采样(收缩)路径遵循卷积网络的典型架构, 的卷积,每个卷积后ReLU, 最大池化,stride为2,每个下采样中,将特征通道数加倍。

- 上采样使用 的上卷积将特征通道数减半,以及拼接下采样的特征图,以及double 卷积+ReLU。

- 优于每次卷积边界像素的丢失,裁剪是必要的?

- 最后一层,使用 卷积将每个 64 分量特征向量映射到所需数量的类。

- 该网络总共有 23 个卷积层。

- 为了允许输出分割图的无缝平铺(see Figure 2),重要的是选择输入平铺大小,以便将所有 最大池化操作应用于具有偶数 x 和 y 大小的层。

Training

- 使用SGD来训练网络

- 为了最大限度地减少开销并最大限度地利用 GPU 内存,我们倾向于使用大输入图块而不是大批量,从而将批量减少到单个图像。因此,我们使用高momentum (0.99),使得大量先前看到的训练样本确定当前优化步骤中的更新

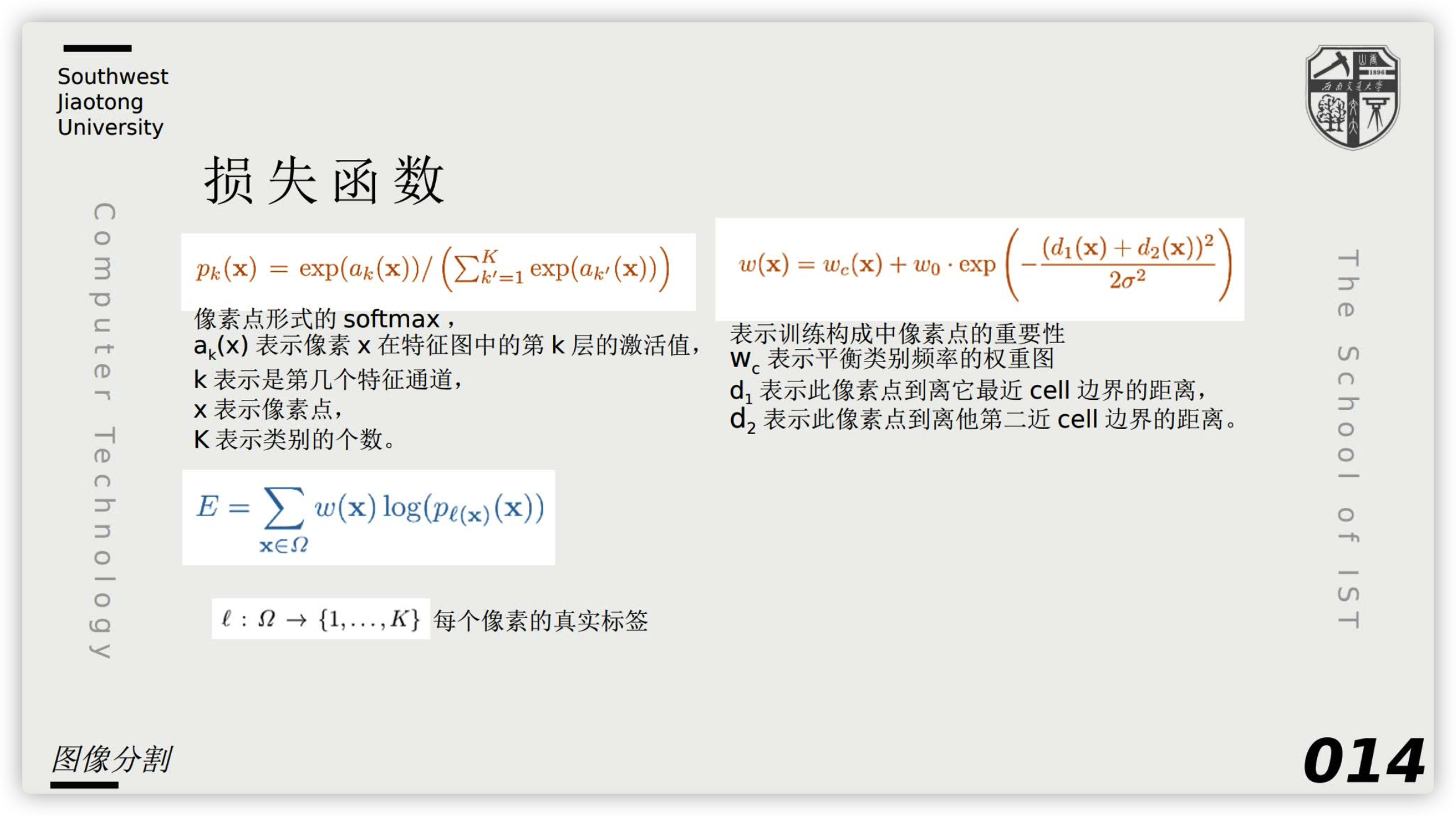

- 能量函数

Data Argumentation

当只有很少的训练样本可用时,数据增强对于教导网络期望的不变性和鲁棒性是至关重要的。对于显微图像,我们主要需要平移和旋转不变性,以及对变形和灰度值变化的鲁棒性。尤其是训练样本的随机弹性变形似乎是训练带有很少注释图像的分割网络的关键概念。我们使用粗糙的 网格上的随机位移向量生成平滑变形。位移从标准偏差为10像素的高斯分布中采样。然后使用双三次插值计算每像素位移。缩路径末端的退出层执行进一步的隐式数据扩充。

Experiments

介绍了在三种不同分割任务的应用结果。

主要是介绍了任务,然后介绍结果。

Conclusion

【最后再总结一下我们的工作真的很棒!性能很棒哦!比方!给你举例最后说一下就结尾哦!】

u-net在不同的医学图像分割应用上都取得了比较好的性能。得益于弹性变形的数据增强,它只需要很少的图像,并且训练时间也很合理,只要10h,我们提供完整的基于Caffe[6]的实现和训练有素的网络,我们确信u-net架构可以很容易地应用于更多的任务。

[6] Jia, Y., Shelhamer, E., Donahue, J., Karayev, S., Long, J., Girshick, R., Guadarrama, S., Darrell, T.: Caffe: Convolutional architecture for fast feature embedding (2014), arXiv:1408.5093 [cs.CV]

参考

- Unet论文详解U-Net:Convolutional Networks for Biomedical Image Segmentation_祥瑞的技术博客-CSDN博客_unet论文

- 深度学习中优化方法——momentum、Nesterov Momentum、AdaGrad、Adadelta、RMSprop、Adam_天泽28的专栏-CSDN博客_momentum

- 一文带你了解深度学习中的各种卷积(上)_小岁月太着急-CSDN博客_一文带你了解深度学习中的各种卷积

- 论文讲解:U-Net: Convolutional Networks for Biomedical Image Segmentation及源码分析_哔哩哔哩_bilibili